注意力机制模型_注意力机制模型

˙^˙ *** 次数:1999998 已用完,请联系开发者***

梁文锋参与著作!DeepSeek最新论文介绍新机制 可使AI模型进一步降本...《科创板日报》2月18日讯(编辑 宋子乔) 2月18日,DeepSeek团队发布一篇论文介绍了新的注意力机制NSA(Natively Sparse Attention,原生稀疏注意力机制)。 NSA专为长文本训练与推理设计,能利用动态分层稀疏策略等方法,通过针对现代硬件的优化设计,显著优化传统AI模型在训练和推...

╯△╰

南通乐创新能源申请基于注意力机制SMOE模型的电池RUL预测方法...金融界2024年11月11日消息,国家知识产权局信息显示,南通乐创新能源有限公司申请一项名为“一种基于注意力机制SMOE模型的电池RUL预测方法”的专利,公开号CN 118914908 A,申请日期为2024年10月。专利摘要显示,本发明公开了一种基于注意力机制SMOE模型的电池RUL预测...

≥^≤ 南通乐创申请基于注意力机制 MOE 模型的电池 SOH 预测方法专利,...金融界 2024 年 11 月 11 日消息,国家知识产权局信息显示,南通乐创新能源有限公司申请一项名为“一种基于注意力机制 MOE 模型的电池 SOH 预测方法”的专利,公开号 CN 118914906 A,申请日期为 2024 年 10 月。专利摘要显示,本发明公开了一种基于注意力机制 MOE 模型的电池 S...

上海壁仞科技申请注意力机制计算和模型推理专利,提升计算效率金融界2024年10月24日消息,国家知识产权局信息显示,上海壁仞科技股份有限公司申请一项名为“注意力机制计算和模型推理方法、装置、设备及介质”的专利,公开号CN 118798263 A,申请日期为2024年6月。专利摘要显示,本发明提供一种注意力机制计算和模型推理方法、装置、设...

大模型的注意力机制给我们的启示通过探索AI如何模仿人脑来提高效率和学习速度,我们可以更好地理解人类的注意力如何在信息泛滥的世界中受到挑战,并找到强化自身专注力的方法。开始一个系列,智能时代的变革与思考大模型的注意力机制给我们的启示大模型的核心:注意力机制现在的大模型比上一代更加智能,上一...

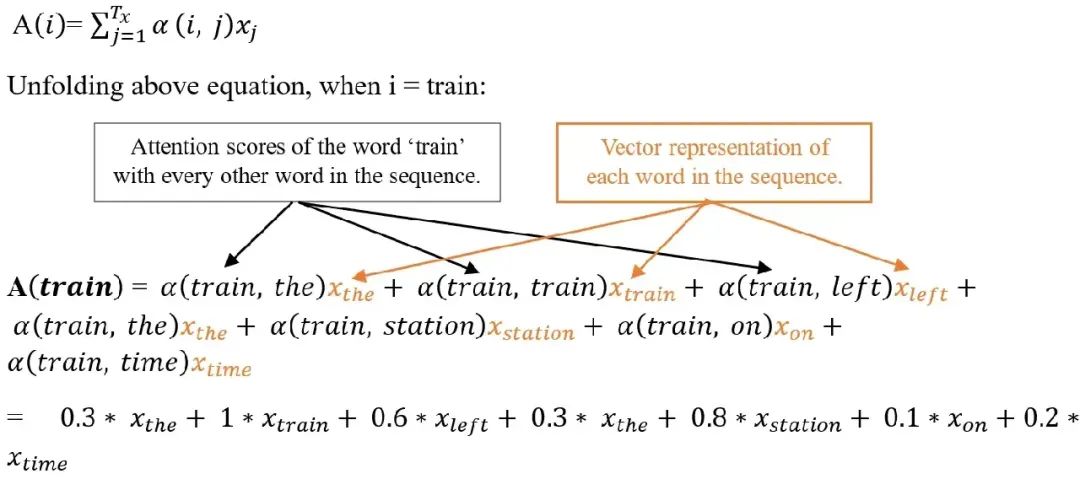

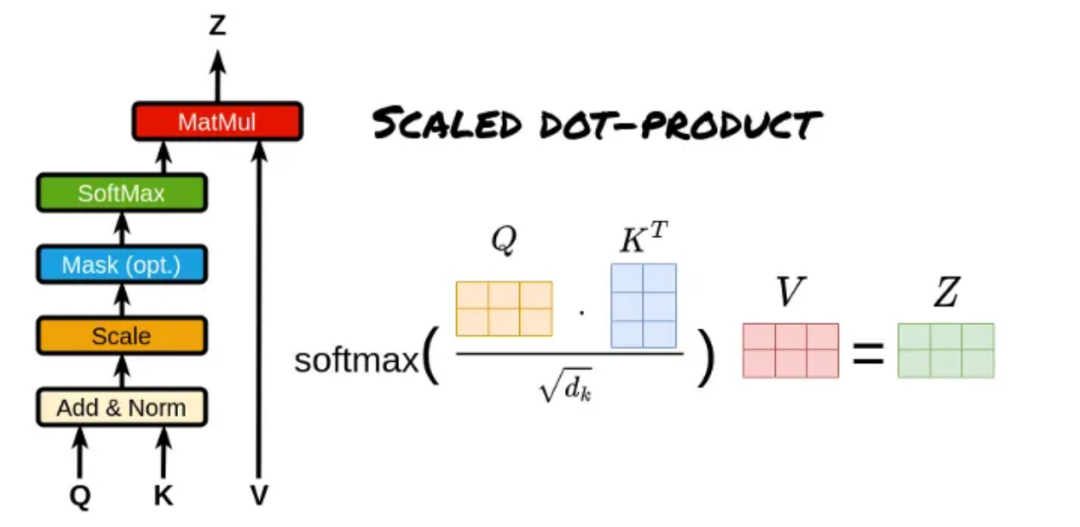

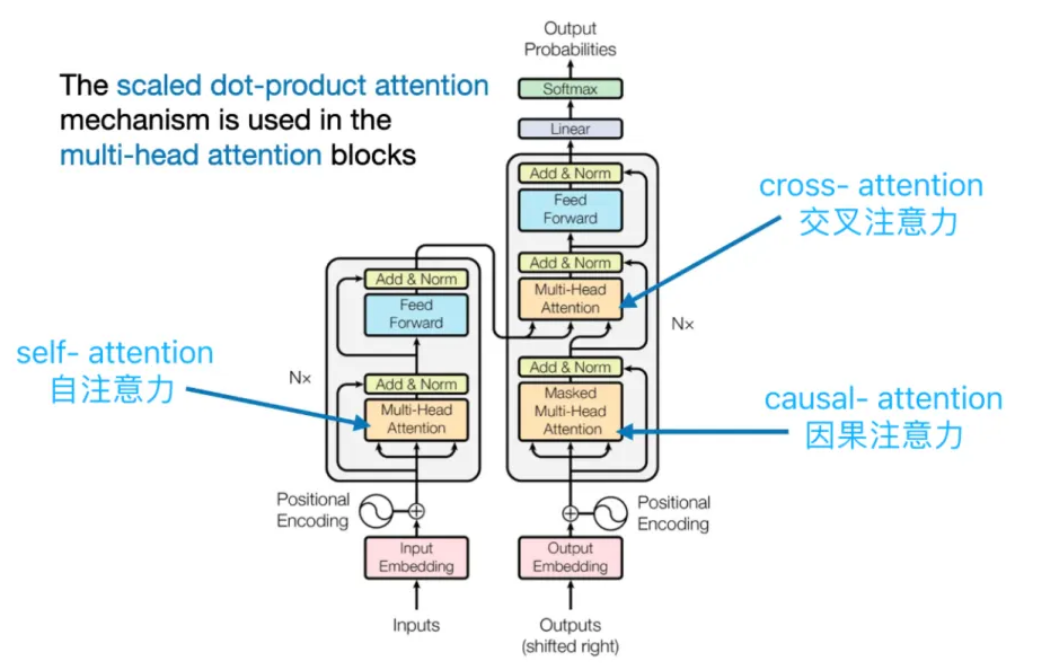

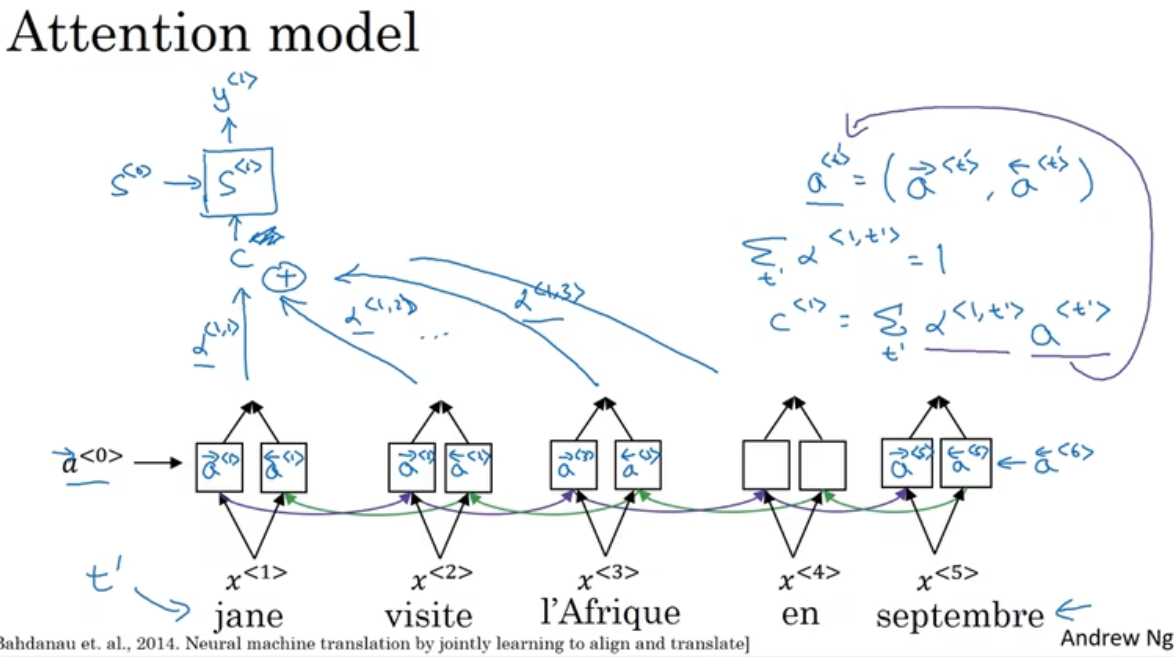

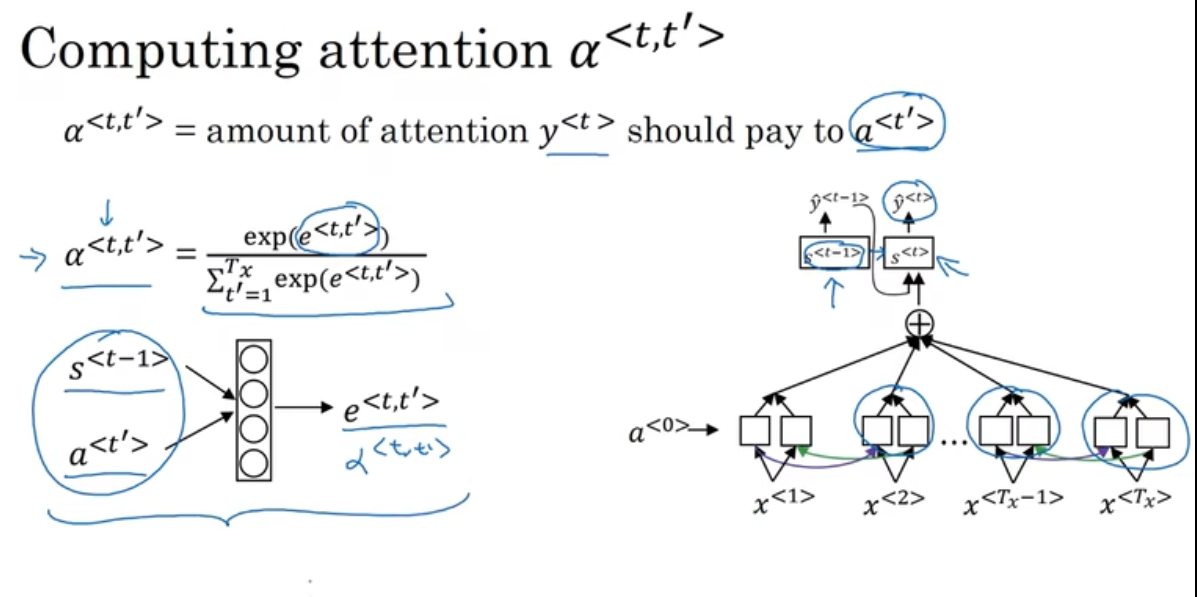

三种Transformer模型中,注意力机制介绍本文深入探讨Transformer模型中三种关键的注意力机制:自注意力、交叉注意力和因果自注意力。这些机制是GPT-4、Llama等大型语言模型(LLMs)的核心组件。通过理解这些注意力机制,我们可以更好地把握这些模型的工作原理和应用潜力。 我们不仅会讨论理论概念,还将使用Python和...

山东港口科技申请基于港口大模型可变型注意力机制的吨袋计数专利,...金融界2024年10月31日消息,国家知识产权局信息显示,山东港口科技集团有限公司申请一项名为“一种基于港口大模型可变型注意力机制的吨袋计数方法”的专利,公开号 CN 118840319 A,申请日期为2024年6月。专利摘要显示,本发明涉及图像处理技术领域,具体的是一种基于港口大模...

MoH:融合混合专家机制的高效多头注意力模型在深度学习领域,多头注意力机制一直是Transformer模型的核心组成部分,在自然语言处理和计算机视觉任务中取得了巨大成功。然而,研究表明并非所有的注意力头都具有同等重要性,许多注意力头可以在不影响模型精度的情况下被剪枝。基于这一洞察,这篇论文提出了一种名为混合头注...

(-__-)b

...兼顾多特征区域的深度学习模型训练方法专利,提升基于注意力机制的...对模型进行再次训练,更新模型参数;重复上述步骤一次或者多次后,切换另一幅图像进行相同的训练,直到训练集图像库中的所有图像均被输入后,模型训练完成,存储模型参数;本方法旨在提升基于注意力机制的深度学习模型的泛化能力和鲁棒性,兼顾多区域特征,避免漏识别。

谷歌公布 Titans 系列模型架构:融合长短期记忆与注意力机制IT之家 1 月 20 日消息,谷歌研究院发文,公布了“Titans”系列模型架构,相应模型架构最大的特点是采用“仿生设计”,结合了短期记忆、长期记忆和注意力机制,支持超过 200 万个 Token 的上下文长度,目前相关论文已发布在 arXiv 上(点此访问),谷歌计划未来将 Titans 相关技术开源。目前...

∩﹏∩

飞飞加速器部分文章、数据、图片来自互联网,一切版权均归源网站或源作者所有。

如果侵犯了你的权益请来信告知删除。邮箱:xxxxxxx@qq.com

上一篇:注意力机制模型

下一篇:注意力机制模型示意图